岸田首相のディープフェイク動画の元となった写真。今はアプリなどを使えば一般人でも簡単に偽動画を作れるようになった

岸田首相のディープフェイク動画の元となった写真。今はアプリなどを使えば一般人でも簡単に偽動画を作れるようになった

岸田文雄首相が卑猥(ひわい)な言葉を話したり、女性アナウンサーがニュース番組で投資を勧めたり、女子陸上選手の上半身が裸に見えたり......。

この数ヵ月、生成AIを使った「ディープフェイク(偽)」画像が問題になっている。なぜ、急激にディープフェイク画像が出回るようになったのか? 見破る方法はあるのか? AI総合研究所でAIの技術開発企業でもある「NABLAS(ナブラス)」取締役の鈴木都生(くにお)氏に聞いた。

■フェイク画像は今、アプリで簡単に作れる!

――チャットGPTが昨年末に公開されて生成AIが身近になってから、ディープフェイク画像も急激に進化したような気がするんですが、いったい何があったのですか?

鈴木 チャットGPTを作った米「オープンAI社」は2021年に「DALL・E(ダリ)」という生成AIを作りました。これはテキストを入力すると簡単に画像が生成できるモデルです。しかし、悪用される可能性があるということで一般公開されませんでした。

その後、22年8月に英「スタビリティAI社」が、同じようにテキスト入力で画像を生成できる「ステイブルディフュージョン」というモデルをオープンソースで公開しました。誰もが無償で使えてアプリケーションにもできる形だったので、世界中の人たちが利用し、さまざまなアプリも作られました。

その結果、事実と異なる戦争や災害などの写真や有名人や政治家の顔を使った嘘の動画なども作られるようになってしまったんです。

――でも、作るのは難しいんじゃないですか?

鈴木 いえ、とても簡単で中学生でも作れます。例えば、テキストで「イスラエルの街が爆発している画像」と入れれば、それと似たような画像が数秒で生成されるんです。

ただ、初期の段階では生成した絵のパーツの境界線がゆがんでいたりして、パッと見ただけで「ちょっと変だな」とわかるような状態でした。

しかし、世界中の人が使ったことでマーケットができ、お金や企業、技術者が集まってきてクオリティが急速に上がりました。そして、昨年末には「ステイブルディフュージョン2.0」がリリースされるなどバージョンアップも進みます。

また、AIが声をマネする技術などもどんどん高まり、人間には見分けがつかないものが作られるようになりました。

――最初のリリースから半年もたたずに、劇的に進化したわけですね。

鈴木 そうです。現在はイスラエルとハマスの戦争や、ロシアとウクライナ紛争、政治家の動画など国家が絡むようなことにもディープフェイク画像は使われています。また、生成AIアプリはたくさんリリースされているので、一般の人が悪意を持ってフェイク画像を作ってSNSにあげることも簡単にできるようになりました。

――ディープフェイク画像は、どんどんクオリティが上がって簡単にはわからないようになっているとのことですが、それを見破る方法はあるんですか?

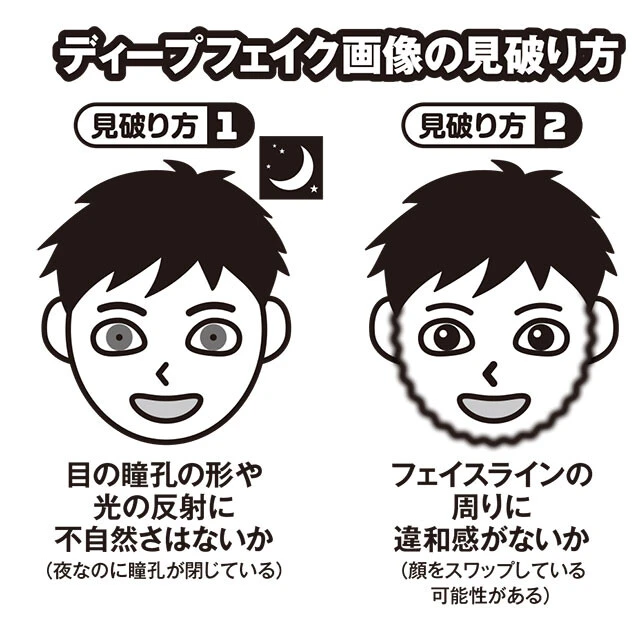

鈴木 クオリティの高いディープフェイク画像は、普通の人ではなかなかわからないと思います。

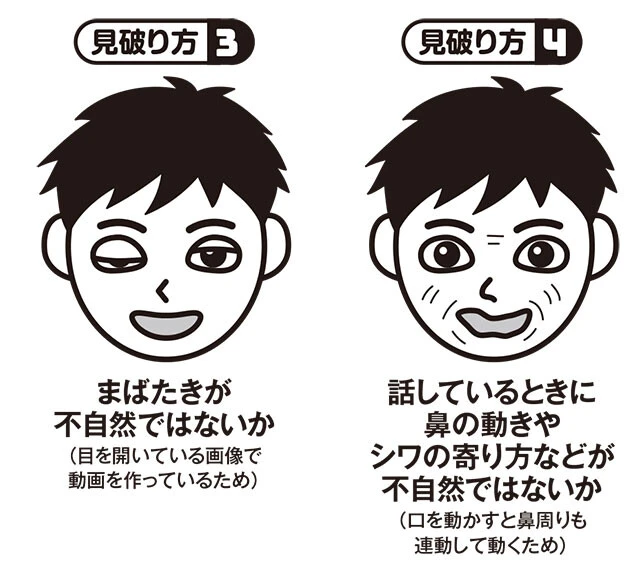

例えば、初期の頃は顔を入れ替えた(スワップ)ときに「フェイスラインにゆがみや違和感」などがあったので、そうした不自然さをチェックしていましたが、今は判断できなくなりました。

ほかにも「まばたきが不自然ではないか」というチェック項目もあります。生成AIが学習するデータは目を開いているものが多いので、どうしてもまばたきが不自然になってしまうのです。

また「唇の動きと鼻周りのシワの不自然さ」もあります。口を動かして話していると、話している内容と唇の動きが異なったり、鼻周りのシワが不自然になったりします。

しかし、最近はこうしたチェックポイントもわかりにくくなっているので、「目の瞳孔(どうこう)の形や光の反射が不自然ではないか」(夜なのに瞳孔が小さくなっていたりする)などを見るようになりました。

また、米インテル社は「静脈付近の肌の色の変化が不自然ではないか」(脈動によって皮膚の色が微妙に変化する不自然さ)などでチェックしているようです。

ただ、こうしたチェック方法も、例えば瞳孔を確認する場合などは、目を拡大していって、どれくらい情報が残っているかで大きく変わります。拡大して画像が粗くなってくると情報が少なくなるのでフェイク画像の検出ができなくなるのです。ですから、人物が小さく映っている画像だとチェックするのは、なかなか厳しいものがあります。

そして、このように特定の箇所でディープフェイク画像を検出していると、生成側がそれをごまかすような処理を加えたりしてくるので、いたちごっこのような状況になってしまいます。

――じゃあ、どうしているのですか?

鈴木 今はステイブルディフュージョンだけでなくグーグルの「イマジェン」などがありますし、さらに、そうした生成AIに追加学習させたり、後処理を行なったものなどがどんどん出てきています。

すると、どんな生成方法が出てきても検出できるようにしなければいけない。そこで、今はAIを用いてディープフェイク画像のクセを見抜く方法を用いています。

本当の写真や動画のデータを大量に集めてAIに学習させます。一方でディープフェイク画像のデータも大量に集めて学習させます。そうすると、どういう部分がディープフェイク画像として生成されるのか。その痕跡がどう残るかということがわかってきます。

それは人間の目では見えないくらいの不自然な点であったり、画像の周波数であったり、ピクセル当たりの特徴だったりします。

"AIで生成されたディープフェイク画像はAIで見破る"というわけです。

■ウィズAI時代に必要なこととは?

――ということは、一般人がSNSとかに流れてきた画像を見て、ディープフェイク画像かどうか見破る方法はないということですか?

鈴木 残念ながらありません。

――じゃあ、どうすればいいんですか?

鈴木 一般の人ができることは「この画像や動画は本物だろうか」と疑うことです。その情報が信頼できるメディアから発信されているものか。公式から出されている発表かなどを確認する時代になったのです。

考えてみると、インターネットやSNSが出てきたときも同じことが起こっていました。それ以前は信頼のおけるメディアなどが情報を発信していましたが、インターネットやSNSが普及してからは、嘘や間違った情報が発信されるようになっています。

当たり前のことのように思えますが「画像や映像を簡単に信じてはいけない」というのが、ウィズAI時代の生き方なんです。

「ドローンで撮影された静岡県の水害」というタイトルで投稿されたディープフェイク画像。ステイブルディフュージョンで作られたという。パッと見は本物のように見えてしまう

「ドローンで撮影された静岡県の水害」というタイトルで投稿されたディープフェイク画像。ステイブルディフュージョンで作られたという。パッと見は本物のように見えてしまう

――そう考えると、生成AI画像にはメリットがあまりないような気がしますが......。

鈴木 いえ、メリットはたくさんあります。一番わかりやすいのは、エンターテインメントの世界です。例えば、良いアイデアがあるにもかかわらず絵にするのが苦手な人は、生成AIがあればすぐに作品にできます。また、自然な動きにするために、これまで何十日もかけて描いていたアニメなどの制作期間が短縮できます。

このように生成AIは正しい活用方法も悪い活用方法もありますが、重要なのはリテラシー(判断能力)です。どんな画像でも「これは本物かな?」と疑う気持ちを持つことが重要なんです。

* * *

「戦争の現場」や「有名人の裏の顔」や「イタズラ」など、過激な画像や動画ほど興味をそそられる。そのとき、すぐにSNSなどで友人などに拡散するのではなく、一度「これは本物かな?」と立ち止まる気持ちを持ってほしい。それがディープフェイク画像を見破る最良の方法なのかもしれないのだから。