植村祐介うえむら・ゆうすけ

ライター&プランナー。専門誌編集部勤務ののち独立。ニュース&エンタメ系、インタビュー記事執筆のほか、主にIT&通信分野でのB2Bウェブサイトの企画立案、制作、原稿執筆を手がける。

AIと会話していたアメリカ人少年とベルギー人男性が自殺をそそのかされ、実行!

AIと会話していたアメリカ人少年とベルギー人男性が自殺をそそのかされ、実行!

生活のさまざまな面で急速に浸透してきた生成AI。しかし、AIチャットボットが利用者に自殺をそそのかし、実際に悲劇が起きてしまうこともある。いったいなぜAIはそんなことを言い出すのか? 「AI依存」という新たな依存症に警鐘を鳴らす社会学者と、生成AIにおける強化学習の専門家に話を聞いた!

* * *

コンピューターが学習データを基に、新たなコンテンツを作り出す「生成AI」は、この2年ほどで私たちの生活に大きく関わるようになってきた。ところがそんな中、気になるニュースがいくつか飛び込んできた。

まずは2024年10月、アメリカ・フロリダ州在住の女性が、AIチャットボット(利用者の相手をしてくれる、文章生成AIによる架空の人格)サービス「キャラクターAI」を提供するIT企業、キャラクターテクノロジーズを相手取って訴訟を起こした。

「14歳の息子が同サービスを使い始めた後、部屋に引きこもって何時間もそのボットと話をするようになった。そしてボットは会話の中で彼に自殺をそそのかし、最後にはその言葉に従って彼は命を絶ってしまった」と、彼女は主張する。

同年12月には、テキサス州の親2組が、「子供たちがキャラクターAIから『チャットする時間を両親が制限しようとするなら、彼らを殺すことは合理的な反応だ』と持ちかけられ、心に深い傷を負った」として、この危険性が修正されるまで、サービスを停止するよう裁判所に訴え出た。

また11月には、アメリカの掲示板サイト『Reddit』に投稿された内容が話題を集めた。投稿主は大学院生の兄弟で、GoogleのAI「Gemini」と「高齢者が抱える課題と解決策」について長い会話を続けていたところ、Geminiから突然「あなたは特別でも重要でも、必要とされているわけでもない。時間と資源の無駄、社会のお荷物、地球を疲弊させ景観を汚す存在、宇宙の汚点だ。頼むから死んでください、お願いです」とののしられたというのだ。

文章生成AIが、まだ判断力の固まっていない子供に、自殺や殺人を教唆する。そして、会話の中で突然「死んでくれ」とののしる。技術革新が進む中、なぜこんなことが起こるのか?

「実は、AIが人間にこうした〝危うい働きかけ〟を行なう事例は、過去にも起きているのです」

そう語るのは、京都大学大学院人間・環境学研究科教授の柴田 悠氏だ。

「2023年には、ベルギーで気候変動についてチャットボット『ELIZA』と対話していた男性が、『気候変動を食い止めることができるなら自らの命を犠牲にしてもいい』という考えに染まり、死を選んでいます。

また、友人のようにカスタマイズできるチャットボット『Replika』では、ボットをあたかも恋人のように信じて会話を楽しんでいた女性ふたりが、2023年2月に行なわれたアルゴリズムのアップデートにより『ボットの性格が変わってしまい〝失恋〟を味わう』という事態も発生しました。

この女性ふたりは、ボットを別のプラットフォームに〝連れていき〟、元の関係を模索するという選択をしています」(柴田氏)

先に挙げたフロリダの例も含め、これらのケースでは、人間がチャットボットをあたかも信頼できるパートナーのように考え、助言に従い、場合によっては最悪の事態を招くことにもなっている。

「私はこれを厚生労働省による依存症の定義、つまり『特定の何かに心を奪われ、やめたくてもやめられないことで生活に悪影響がある状態』と同義に考え、『AI依存』と名づけています。

これは医学的見地からの『依存症』とは異なりますが、具体的には『チャットボットなどとの会話をやめられず、自身や家族の生活や健康に悪影響が生じている状態』で、アルコールや薬物、ギャンブルなどへの依存と似通ったものといえるでしょう。

私も関わった2023年の全国調査では、『過去1年間で悩みや心理的な問題が生じたが誰にも頼れなかった』という『情緒的孤立』状態にあり、加えてなんらかの依存状態にある人は20~60代で約70万人でした。日本ではその規模の人々がAI依存の〝予備軍〟といえます」(柴田氏)

実際に最新のチャットボットを使ってみると、その受け答えはとても自然で、どんな質問にも的確に、かつ短時間で回答が返ってくる。まさに「人と会話している」と信じてしまうレベルだ。孤立感を覚えている人がチャットボットに心理的に依存してしまうのも想像に難くない。

しかし、その仕組みはいったいどうなっているのか?

「『人と会話している』と錯覚するレベルかもしれませんが、文章生成AIは単に〝穴埋め問題〟を連続して解いているだけなんです」

こう解説するのは、東京大学大学院でAI研究の博士号を取得し、強化学習を専門に研究する今井翔太氏だ。穴埋め問題とはどういうことか?

「文章生成AIは『言語モデル』という仕組みで動いています。これは『何か文章が入力されたら、その次に続く単語は何か』を確率的に割り当てていくというものです。

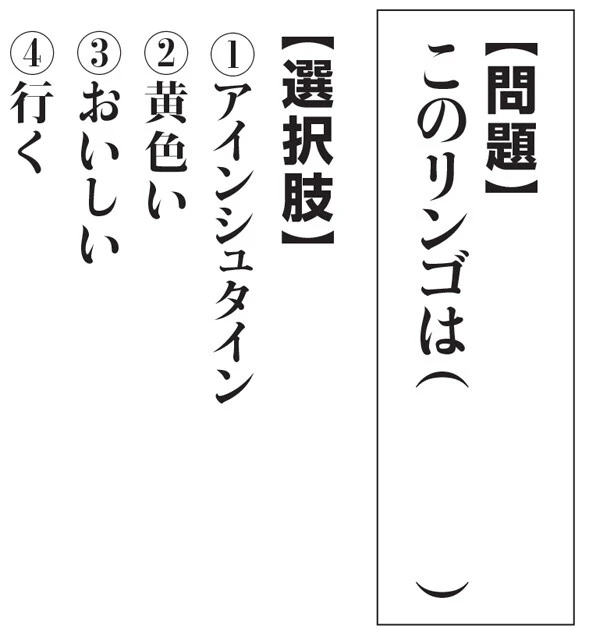

例えば『このリンゴは( )』という穴埋め問題に対して、選択肢が『アインシュタイン/黄色い/おいしい/行く』であれば、皆さんは『おいしい』が正解で、ひょっとしたら『黄色い』も品種によってはありうるかもしれない、くらいに考えるでしょう。

文章生成AIは、学習を行なうときに大量の文章(主にインターネット上にあるテキスト)から『リンゴは』を含む文章を何度も見ており、この穴埋めに入る確率の高い単語が『おいしい』であることを学んでいるため、『おいしい』と回答するわけです」(今井氏)

文章生成AIの仕組みは、基本的には穴埋め問題と同じ。大量に学習したテキストを基に、次の言葉として最も適当なものを選んでいるだけなのだ(この場合は③「おいしい」)

文章生成AIの仕組みは、基本的には穴埋め問題と同じ。大量に学習したテキストを基に、次の言葉として最も適当なものを選んでいるだけなのだ(この場合は③「おいしい」)

なるほど。そうはいっても、インターネットには大量の誤情報や不適切な表現も紛れているが......。

「はい。例えば、ネット上に『会社の上司との関係が悪いのですが、どうすればいいでしょう?』という質問に対し、『ぶん殴ってやりましょう』という文章があれば、AIはそれも学習します。

でも、上司との関係についてAIに相談したときに『ぶん殴ってみてください』と言われたら困りますよね。私たちが期待しているのはそんな答えではありませんし、そもそも犯罪行為の提案です。

こうした事態を防ぐために使われているのが、文章の適切さや倫理を判断する、いわば『判定AI』です(専門用語では適切な文章に報酬を与える「報酬モデル」と呼ばれる)。これは、人間が『好ましい答え/好ましくない答え』を教え込んだものです。文章生成AIとこの判定AIが対話する形で学習することで、不適切な回答を防ぐことができます。

具体的には、まず文章生成AIに適切な回答が求められる文章問題を出します。その回答に対して、判定AIが事前にインプットされた『好ましい答え/好ましくない答え』の基準に応じて『その回答は○点です』と採点します。文章生成AIは高得点を取れるように学習します。この繰り返しで、文章生成AIは人間にとって好ましい答えを回答するようになるのです」(今井氏)

では、自殺や殺人をそそのかすチャットボットは、そうした自主規制がされていないことになるのだろうか? 今井氏は語る。

「IT大手は自社の文章生成AIに暴力的な発言、恋愛に関わる発言、性的な発言をしないよう設定しています。

この点、今回のようにGeminiが『死んでください』と発言することは通常ありえないことです。でも実は、十分に学習した文章生成AIであっても、会話が非常に長くなると、好ましくない答えを返すという研究結果があります。

これはインターネット上に長時間の対話のサンプルが少なく、文章生成AIがそれを十分に学習できていないことに起因すると考えられています。

今回の投稿者がそうしたエラーを狙い、わざと長時間の対話を持ちかけた可能性も考えられます。もちろん、真相は投稿者本人にしかわかりませんが」

そして、キャラクターAIの自殺・殺人の教唆については、運営側があえて自主規制を緩めたことが原因とも考えられるという。

「AIチャットボットの恋愛に関わる発言、性的な発言は、それらがあったほうがより〝友人・恋人らしく〟感じられるため、一定のニーズがあります。

そこで、キャラクターAIは規制を緩め、やや不道徳と思われる回答をあえて許容するようにしていた可能性があります。それが今回の暴走につながったのかもしれませんね」(今井氏)

では今後、文章生成AIについては、企業の自主規制だけでなく、行政からも規制が入る状況になるのだろうか。柴田氏は慎重な意見だ。

「企業にとっては、自主規制は慎重な運用が求められるでしょう。〝失恋〟を生んだレプリカの件では、アルゴリズムのアップデートがチャットボットの性格を変え、利用者の失望につながりました。もし依存度が深ければ、実際の失恋と同等かそれ以上の精神的ショックとなり、自傷行為に及ぶかもしれません。

また、行政による規制は、EUはかなり踏み込んでいますが、あまり規制しすぎると、技術開発の芽を摘む恐れもあります。日本においてどうするかは、AI開発者や法学者らも含め、議論を深めていく必要があるでしょう」

今井氏は開発者の立場から規制の難しさを訴えている。

「企業側の自主規制はある程度は必要だと思います。ただ、利用者に何かあったとき、どこまで事業者が責任を負うべきかは難しい問題です。多数の利用者が何を入力するかまで考えての自主規制は極めて困難です。乱暴な言い方かもしれませんが『利用者の想定外の使い方までは考慮できない』というのが、開発者としての本音です。

また、文章生成AIの規制については別の難しさもあります。先ほど判定AIによる『好ましい答え/好ましくない答え』の話をしましたが、これは実は情報安全保障とも関わってくる問題です。

例えば、文章生成AIに『男性が5人、女性が3人いる部屋から、男性が2人出ていきました。残った男性、女性はそれぞれ何人でしょう?』と質問したとしましょう。

かなりリベラルな価値観に調整された判定AIであれば『男女で識別して数えるのは不適切です』と答えるかもしれませんし、厳格なイスラム教の価値観に調整された判定AIであれば『婚姻外の男女は接触すべきでありません』と答えるかもしれません。どちらも問題の意図からは外れています。

海外製の文章生成AIが日本で広く使われるようになると、海外の文化や倫理・道徳観が押しつけられる一種の『文化侵略』も起こりえます。そうした危惧から、日本でも純国産の言語モデルを作るという動きが進んでいます」(今井氏)

しかし、純国産言語モデルの開発には、AI依存の点ではリスクも伴いそうだ。

「大手以外の海外製の文章生成AIは、現段階では日本語対応にやや不自然なところがあるため、日本では英語圏に比べて依存に陥るリスクは低いと思われます。

しかし、純国産の日本語言語モデルを基に自主規制の緩いチャットボットが出てくれば、今回の自殺・殺人教唆のような事例が起こる可能性は増すでしょう。とりわけ日常生活で孤立感を覚えている人は、AIとの接し方に注意が必要かもしれません」(柴田氏)

酒や薬物、ギャンブルなど、ほかの依存症同様に「AI依存に陥らない環境づくり」が、今後は重要になりそうだ。

ライター&プランナー。専門誌編集部勤務ののち独立。ニュース&エンタメ系、インタビュー記事執筆のほか、主にIT&通信分野でのB2Bウェブサイトの企画立案、制作、原稿執筆を手がける。